コムアイとオオルタイチによるプロジェクト“YAKUSHIMA TREASURE” 、プロジェクトが生まれた地・屋久島にあるガジュマルの森にて実施したライブパフォーマンスがインタラクティブな映像作品『YAKUSHIMA TREASURE ANOTHER LIVE from YAKUSHIMA』として、2021年3月31日までオンライン配信されている。コロナ時代に失われた「ライブ体験」をテクノロジーで新しい表現形態として作るというプロジェクトだ。

手掛けたのは、Dentsu Craft Tokyo(デンツウ・クラフト・トウキョウ)。『YAKUSHIMA TREASURE ANOTHER LIVE from YAKUSHIMA』では、リアルなライブ体験ではなく、テクノロジーを駆使し、肉眼で捉える光景や実写のライブ配信映像とも違う、新しいかたちの体験をオンスクリーンで提供している。

屋久島・ガジュマルの森にPAシステムを360°サラウンドで構築し、ライブパフォーマンスの一発録りに挑戦。空間をLiDARやフォトグラメトリーによって360°の点群データとしてスキャンし、アーティストのパフォーマンス収録にはKinectを使ったボリュメトリックキャプチャを用いている。LiDARやフォトグラメトリーで捉えた形状・色彩、kinectで読み取った動き、サラウンド音響を360°マイクで立体的に収録した音像を収集し、その時の現場のデータを再構築し映像表現に落としこんだ。サイト上では、視聴者はアーティストと距離が無くなるくらい近づき、森の中を上下左右に飛び回り、物理的制約を超えた自在な視点でライブパフォーマンスをみつめることができる。このプロジェクトに、Unityが活用されている。

今回、プロデューサーの宮下研也氏、テクニカルチームの村田洋敏氏、朝倉淳氏、黒川瑛紀氏(以上Dentsu Craft Tokyo)、堀宏行氏(汎株式会社)にこのプロジェクトがどう生まれたのかお話を聞いた。

「ライブとは何か」という根源的な問いから始まった

──まずは、このプロジェクトが始まったきっかけについて教えてください。

宮下:YAKUSHIMA TREASUREのスタッフの方からお話をいただいたのですが。コロナ禍の中で、人が集まる事が難しく、芸術やエンタメ、ライブ等のパフォーマンスの機会がすごく減っていて、この状況をテクノロジーで何か変える事ができないかというのがプロジェクトの始まりでした。

僕たちDentsu Craft Tokyoは映像も作れるし、優秀なテクニカルチームも揃っているので、何ができるのか一緒に考えてながらやっていく事になりました。

──それではテクニカルチームのご担当を教えていただければ。

村田:テクニカルディレクター・エンジニアとして活動しております。普段からインスタレーションやライブ演出などの仕事をしているんですが、今回はテクニカルディレクション部分とTouchDesignerやUnityを使った実装を担当しました。

堀:堀です。今回のプロジェクトではテクニカルディレクターという形で入ってます。できるだけ大きな視点から本プロジェクトを見ようとしました。例えば最初にどういったプラットフォームで作品を作っていくのがいいのか、Webで表現するか、VRデバイスで表現するべきなのかといったことの議論のきっかけを作ったり、他にも、監督との一番最初のコミュニケーションの取るとっかかりなど意識しました。普段の仕事はテクニカルディレクションをやることが多いですが、領域的にはクリエイティブと言われているようなインスタレーションだったり、広告施策をやったり、一方スタートアップなどの創業の手伝いや商品開発の手伝い等の活動もしています。

朝倉:私はDentsu Craft Tokyoでエンジニアをやっています。今回のプロジェクトだとUnityのVFX Graph周りを主に担当しました。普段もUnityでビジュアルを作ったり、Web関係のプロジェクトに関わっています。

黒川:普段の業務ではWebのフロントエンド周りと、あとはUnity等でインテラクティブコンテンツの開発を担当しています。今回はUnityから書き出し、生成した映像等の情報をもとに、Web上でストリーミングしたり、再生したり、演出を追加したりという、実際にウェブ上で見られる形にするためにWeb GLとUnityの連携部分を担当しました。

──ありがとうございます。本企画ですが、最も難しい、乗り越えるべき壁はなんでしたか?

宮下:アーティストの想いをどう具現化するかということですね。最初はVRの方が良いのではないか、スキャン以外の方法がないか、実写もやるべきか、など様々な技術の可能性があり、Dentsu Craft Tokyoが中心となり、表現技法のリサーチとテストを行いました。

その後、映像ディレクターをお願いした辻川幸一郎監督と一緒に演出と技術の方向性を決めることからスタートしました。

堀:辻川監督やアーティストとの会議でよく議題にあがっていたのは、「ライブとは何か」ということです。つまりMVやPVを撮影するのではなくて、「ライブを新しい形で配信する」ことをどうやったら実現できるかということを考えたときに、「何があったらライブなのか」というそもそも論を話し合いました。辻川監督はMVやPVをたくさん作られている経験がある方だから、テクニカルチームとの協業をする上で、「ライブ」をどのように考えるかというところを全員が共有して作っていくことをしないと、足並みが揃わない。だから全員で「ライブ性」を考えて、最終的に今の形に落ち着きました。

Unityを用いた映像表現の作り方

──なるほど。Webというスタティックな形でライブ性を持たせるというのは相反した要素を実現するチャレンジだったんじゃないかと思うんですが、そのあたりをどうやってクリアしていったんでしょうか。そもそも、なぜUnityを採用したんですか?

村田:企画の段階から我々テクニカルチームが入れたのがすごくありがたかったです。最初にやったのは、神奈川のキャンプ場にいって色んな撮影手法を使って、いくつかの方向性を試したことです。LiDARなどの3Dスキャン以外にも、いわゆるVRカメラで収録した全天球の映像をスリットスキャンなどのエフェクトと組み合わせてたり、ドローンを使ってみたり、技術的なリサーチを実際に作りながらやってみました。それらを辻川監督に見ていただいて、そこでLiDARの3Dスキャンをポイントクラウドで表現した素材が可能性があるのではと感じていただき、今回のスキャンデータをポイントクラウドで表現するという方向性が決まりました。

──かなり丁寧なリサーチを重ねていったんですね。

朝倉:リサーチ時に、LiDARでスキャンしたデータをUnityを使うことで簡単にプレビューしたりエフェクトをかけたりする事ができました。高橋啓治郎さんが公開しているPcx(https://github.com/keijiro/Pcx)を使えば、ポイントクラウドを簡単にVFX Graphに読み込む事ができたので、すごくありがたかったです。

──今までにない企画ですが、絵コンテなどは作ったんですか?

宮下:作成していただきましたが、所謂Unity上の空間にアーティストのパフォーマンスとロケーションを構築できるかが大事でして。要はその舞台をきちんとスキャンして、Unity上で撮影と編集がすべてできるようにスタンバイすることが、今回の「撮影=スキャン」だったんです。絵コンテであらかじめ構成を作っていただいた上で、Unity上で後からアングル、ライティング等、何でもできてしまうので、現場では「いかに精度を良く撮る」ことが大事でしたし、堀さんが場所に応じたスキャン描画方法をちゃんとやって下さったのが大きかったですね。

──やっぱりエンジニアたちが「ここまで表現できます」ということを確かめてから映像のディレクションに入るのがすごく健全なことですよね。そういう面でも、新しい作り方だなと思いました。

村田:なかなか普通のクライアントワークだとそうもいかないことも多いんですけど、最初から僕たちに自由に任せて頂いていたというのが大きかったですね。

──なるほど。技術的に苦労したところを教えてください。

村田:ポイントクラウド表現で行くと決まってからは、撮影までの準備が大変でした。パフォーマンスはkinectを複数台使って収録する必要があったので、屋久島の森の中に持っていく事が可能な複数台のkinectを同時に撮影できるようなシステムやプログラムを急いで作りました。

──どのようなシステムを組んだのですか?

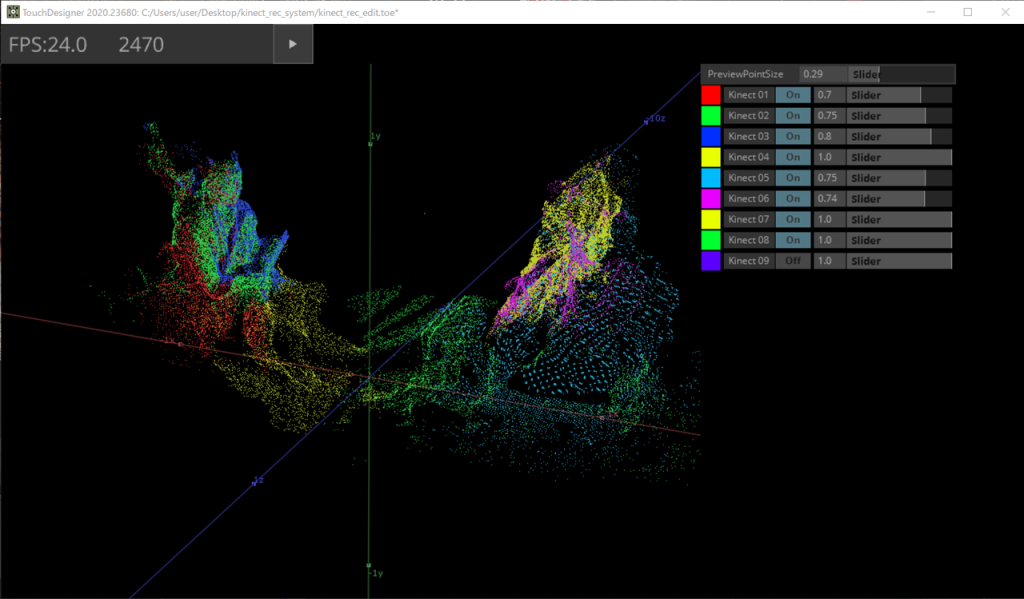

村田:9台のKinectとラップトップ6台でシステムを作りました。1台のラップトップに2つKinectを繋げて、ネットワーク経由で同時にデータを収録できるシステムにしました。Kinectの収録プログラムはTouchDesignerを使って作っています。

堀:Kinectでは演者の演奏を3Dのアニメーションとして収録しています。その他にLiDARとフォトグラメトリーという手法を使い、静止した3Dデータを作りました。それらをUnity上で一つの空間に再構築して今回の作品を作っています。

──なぜその3種類になったんですか?

堀:Kinectは動きを含めて収録できるので演者のパフォーマンスのスキャンで使用しています。フォトグラメトリーは一眼レフで撮った写真が元になっているので、カラーデータがすごくリッチだという理由と、自分たちで撮りたいところが撮れるというメリットがありました。LiDARは遠くまで撮影できるのが一番大きいメリットです。近景の3Dデータだけではなく、数十メートル先までも撮れるので、LiDARを使い周辺を広い範囲で3Dとしてスキャンしています。

村田:9台のKinectで収録したデータはTouchDesignerで位置合わせとノイズ除去などをして、一体化したポイントクラウドのデータを作り、それをUnityに持っていきました。

村田:ここで苦労したのは、Kinectで撮影したポイントクラウドのデータは動画なので非常にデータ量が大きく、Unityで読み込むところで苦労しました。TouchDesignerでポイントクラウドの位置とカラーの情報をそれぞれテクスチャデータにしてSpoutというアプリケーション間でテクスチャデータを共有できる仕組みを使ってUnityに読み込みました。ここでも高橋啓治郎さんが作ったプラグインのKlakSpout(https://github.com/keijiro/KlakSpout)が役に立ちました。

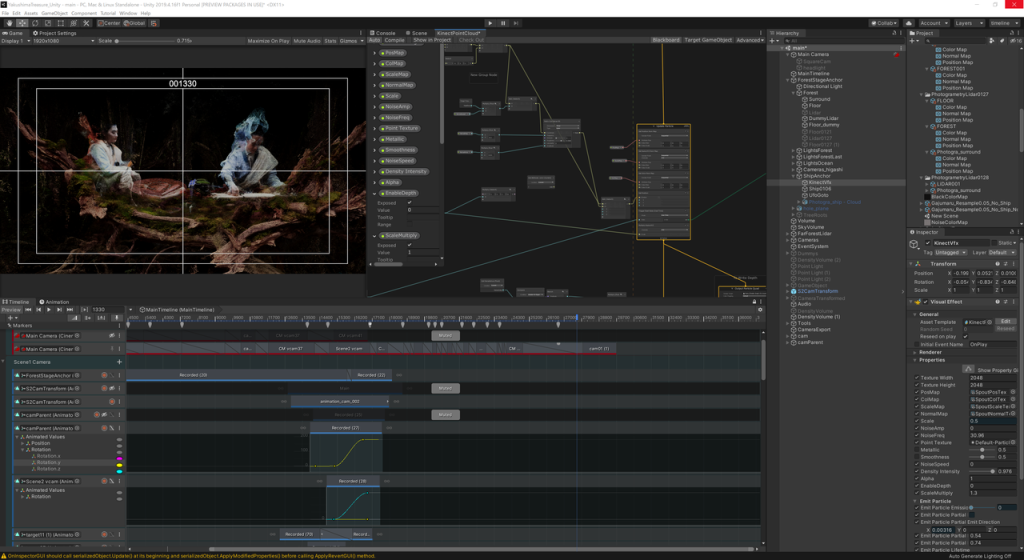

村田:テクスチャーとしてUnityで読み込んで、それをVFX Graphでポイントクラウドとして表示しています。Unity上でLiDARやフォトグラメトリのデータとも位置合わせをして、屋久島の舞台をUnity上で再構築をしてから監督とカメラワークを探っていくというワークフローでした。

──Unity上でカメラワークなども全てやられていますよね。

村田:そうです。さらにライティングもUnity上でやっています。どういうシーンとして見せたいのか、どこを隠したいのかということも、Unityだとリアルタイムでライティングやカメラ位置を試すことができたので、監督とのやりとりもスムーズに進める事ができました。

堀:最初、監督は「本当にUnity上でライティングまで出来るの?」と懐疑的だったんですが(笑)、そこはとにかく信じてくれと説得しました。

──とにかく、あらゆるデータを撮影しておいて、後からどんな風にでも編集できるようにしたというやり方だったんですね。撮影はどのくらいかかりましたか?

堀:瞬殺です。ライブは一発撮りで、その後にガジュマルと船のスキャンも行いましたが、前夜に設営して、朝がライブ本番で、その日のお昼にはもう撤収していました。

村田:本番収録は20分くらいで終わりましたね。もう一発OKです。

──Unityを使った表現で気をつけたところはどういった点ですか?

村田:今回の映像で表示されているものは全てVFX Graphを使って表示しています。VFX Graphはとにかく、ポイントクラウドを使うためにすごくありがたい機能でした。VFX Graphを使った表現やエフェクトは朝倉さんが、いろいろ開発してくれました。

朝倉:高橋啓治郎さんがVFX Graphの情報をたくさん発信していて、それを見て自分で勉強して使えるようになれました。VFX Graphがなかったら、自分でコンピュータシェーダーを書いて作るしかなかったので、それを省略できたのが大きかったです。VFX Graphがなかったら、今回の作品は出来ていなかったかもしれません。

──これだけのデータだと、重くなりませんでした?

村田:ポイントの数でいうと、ざっくり計算すると1億3000万ポイント以上あると思います。ですので、結構ハイスペックのPCを用意していたんですが、だんだんリアルタイムではきつくなったということはありました。

──軽いとは言えど、重くなってしまう。

村田:今回はUnityからは最終的に映像として書き出す仕様だっったので、多少FPSが落ちてもUnityRecorderで書き出しをすれば全く問題はありませんでした。辻川監督もUnity上でここまで、カメラワーク、ライティングなどできる事に驚いていました。

朝倉:VFX Graphを使うと、プロトタイピングがすごく早くできることで演出の判断も早くなって、試行錯誤を繰り返すことができるので最終的に良いものが作れたのかなと思っています。

「ゲームっぽくない映像」をUnity上で実現

村田:ライティングやVFX Graphを使ったエフェクトなども色々と試したのですが、気をつけたのは、辻川監督のこだわりとしてCGっぽかったり、ゲームっぽく見えないようにしたいということでした。

なので実際にポイントクラウドとして物が存在している空間を意識して、エフェクト的な演出は最小限にして、極力アーティストのパフォーマンスやガジュマルの森の世界観とカメラワークで作品として成立するような表現を目指しました。

今回UnityはHDRPを使っているんですが、HDRPと3Dスキャンデータの相性もよかったと思います。特にフォトグラメトリのデータは素材自体が実写をベースにしてるっていうもあって、HDRPでライティングするとかなり見た目がリッチになり、辻川監督もすごく喜んでいました。

朝倉: HDRPではフォッグのボリューム感が綺麗に出るので、印象的に使えましたね。

──Webサイトでのインタラクティブ部分はどのように実現しているのですか。

黒川:Webサイトでは、視聴者はUnityで生成した映像を見ています。それに加えて、「魂」、白いオーブのようなものが飛んでいます。これは実はWeb上でリアルタイム表示されているもので、今までにサイトを閲覧したユーザーのマウスのデータだとかそういうものをサーバー上に保存して、それを後から他のユーザーがまた見たときに、前のユーザーの挙動を追体験して見ることができるんです。それが肝で、ライブ特有の「みんなで一緒に見ている」空間を再現する試みをしていました。

──Web上でUnityとそういった仕掛けを融合しているんですね。

黒川:課題は、Unityから書き出される映像自体がプリレンダーになってしまうので、リアルタイムの魂とどう同期させるかということでした。それで考えたのが、カラーのほかにデプスとカメラ情報を書き出してもらったんです。実際にユーザーが見えてるのはもちろん上半分のカラーの部分で、下半分を深度の情報としてもって魂の描画に活用しました。

黒川:つまり、Unityからカメラの位置や回転などの情報を毎フレーム分書き出してもらい、さらに深度の映像を合わせることで、WebGLで最終的な描画をしています。ですから、WebGL上のカメラに同期させて、実際のプリレンダーであるUnityのカメラ位置とリアルタイムのWebGLのカメラ位置のマッチングを実現したんです。そのために、ミュージシャンの手前に魂が表示されないように、深度が表示される層をある程度決めることで、UnityのカメラとマッチングしたWebGLの映像も同期して合成することができました。

村田:途中、現場のスキャンデータに基づかない地下のシーンがあります。そこで表示されているオブジェクトも、基本的には屋久島でスキャンしてきた岩や木などになっています。ここは空気感とカメラワークで視聴者が別の世界に連れて行かれるような感覚になれば良いなと思っています。

このシーンから次の海のシーンは実際の現場の再現ではないので、監督と時間をかけてどのようなシーンにするのかをUnityでいろいろ試しながら作っていきました。

──それはすごいいいコンビネーションですよね、映像作家とテクニカルチームが全力を出し切れる環境だったという。

村田:そうですね。他には、カメラは1カット長回しで、全部連続的なカメラワークになっているんです。これも辻川監督のこだわりでした。そうすることで「魂の目線」に自分がいる感覚が際立っています。そのためにはUnityのTimelineとCinemachineという映像制作向けの機能を使いました。初めて使ったんですけど、コツを掴むと使いやすいなと感じました。

バーチャルカメラを配置していくのはCinemachineの作り方なんですけど、そのバーチャルカメラ同士をTimeline上で繋げれば、あとは自動で補完してもらえるので、見せたいカットを決めて色んなカメラを置いて、それらをつなげていくような形でまずは作っていって。そこから細かい調整をすごいしていったみたいな作り方ができたのは良かったですね。

──じゃあほんとに一般のカメラで撮影するの遜色ないような。

村田:ですし、Unityでつくることによって実際はあり得ないようなカメラワーク、顔の中を突き抜けていくとか、地面の中に入っていくとか、そういうのもできたのがすごい面白かったなと僕は思ってます。

黒川:Unityを使って、ポイントクラウドや複雑なカメラワークができたのに加えて、デザイン的にもかなり詰めたので、スタイリッシュな仕上がりになったので満足しています。「ライブ感」とというか、生命の営みというものが、テクニカルサイドのこだわりとしても表現として良くできていると自負しています。

最終的にはインスタレーション化を

──サウンドにもかなりこだわられているんですよね。

堀:はい。さっき村田さんがおっしゃった中盤のシーンですが、水の中から出てくると同時に、音も自ら浮きだってモゴモゴした音から、スパッとクリアな音に変わるんですうよ。そこは音チームが頑張ってくれて、気づいた時には鳥肌ものでしたね。

宮下:サウンドチームは、現場でもちゃんと3Dで360度で空間を囲むようなスピーカーの配置にしてくれて、今回のWebではLRですが、実際にはバイノーラルになっているんです。そういった収録の技術と現場での音の出しもものすごく丁寧に制作してくれています。

朝倉:だから、是非サイトはヘッドホンで聞いてほしいですね。鳥の鳴き声とかも入っていますが、現場で鳥が鳴いていて、それがそのまま入ってるんです。本当に「ライブ」なので、そういうところもアーティストのこだわりなので、映像の他にも音にも注目してもらえるとうれしいです。

──ぜひヘッドホンで視聴してみます。それでは今後の展望を教えてください。

村田:サイトは3月31日で閲覧が終了しますが、今後はインスタレーション化など他のプロジェクトにも発展できたらなと考えてます。リアルタイムレンダリングでVRで入れるようにしたり、空間プロジェクションでインタラクションできるようにしたり、Unityを使って作っていたおかげで、色々と展開できる可能性があると思います。

──今後も楽しみにしています。ありがとうございました。

『YAKUSHIMA TREASURE ANOTHER LIVE from YAKUSHIMA』公開情報

配信日時 : 2021年2月11日(木)11:00~ 3月31日(水)

視聴形式 : ウェブ配信

料金 : 500円

※詳しい視聴方法、推奨環境、注意事項に関しては、『YAKUSHIMA TREASURE ANOTHER LIVE from YAKUSHIMA』公式サイト(https://another.yakushimatreasure.com/)をご確認ください。